TYGODNIK TVP: Czym AI i różni się od zwykłego programu komputerowego?

MAREK GAJDA: Każdy program składa się z dwóch elementów: kodu, który opisuje, co ma robić oraz bazy danych, z której korzysta. Największą różnicą jest to, że w przypadku AI program nie posiada zbyt wielu informacji wskazujących, co ma robić, za to bazę danych ma gigantyczną. Nazywa się ją „zbiorem uczącym”. To my mamy AI czegoś nauczyć, by ona na podstawie tego wykonywała jakieś konkretne czynności. Tymczasem zwyczajny program komputerowy ma w kodzie podane jak na tacy wszystko – dokładnie wskazane, co i jak robić.

Zobrazuję to na przykładzie programu do gry w szachy. W klasycznym podejściu opisalibyśmy w tysiącach linii kodu wszystkie procedury prawidłowej gry: jak ruszają się pionki i figury, ruchy dozwolone i zakazane itd. Do tego polecenia, co program ma zrobić w konkretnych sytuacjach, typu: przed wykonaniem ruchu upewnij się, że twój pionek/figura jest kryty, a jeśli możliwości ruchu jest wiele, to dodajemy algorytmy wyboru „mniejszego zła” albo „większego dobra”. W kod wpisany byłby w detalach sposób wygrywania w szachy.

Natomiast tworzenie AI do gry w szachy polegałoby przede wszystkim na przygotowaniu zbioru wszystkich rozegranych partii z ważnych rozgrywek (są dostępne w internecie), bez wskazywania, co dokładnie program ma z tym zrobić. Czyli coś w rodzaju: pooglądaj sobie te partie uważnie, a potem sam graj i wygrywaj – taki masz cel.

Nadal to wydaje się magiczne. Czyli AI sama się koduje? I czy potem można z niej wyciągnąć zapis tego, co i jak sobie na zbiorze danych przygotowała i wykonała?

No właśnie nie do końca można zajrzeć „pod maskę”, zwłaszcza w nowych rozwiązaniach typu

deep learning (głębokie uczenie), gdzie programom przedstawiane są naprawdę szczegółowe dane, do najmniejszego detalu, i to bez podawania ich kontekstu. Maszyna zupełnie sama decyduje, w jaki sposób je uporządkować i jaką im nadać wagę. A liczba tych danych jest tak wielka, że człowiek nie jest w stanie zobaczyć, co ten algorytm zrobił.

ODWIEDŹ I POLUB NAS

ODWIEDŹ I POLUB NAS

Zatem AI potrafi analizować dane i wyciągać z nich wnioski. Powstaje wtedy stały kod, który stara się działać jak ludzki mózg – na zasadzie sieci neuronowej. Mamy np. w telefonie dwie modne dziś aplikacje: jedna służy do rozpoznawania marek samochodów, a druga – gatunków roślin. Obie działają tak, że robimy zdjęcie obiektu, a algorytm zgaduje, co to jest. I obie, oparte o AI, są dokładnie takie same: to sieć neuronowa, która ma się nauczyć „rozpoznawania czegoś”.

Użytkownik może na nie wpływać? Na przykład jako botanik mogę zobaczyć błąd aplikacji w klasyfikacji jakiejś rośliny i poprawić go dla dobra innych użytkowników?

Niektóre programy umożliwiają korygowanie przez człowieka rozwiązań podanych przez maszynę. Wtedy ona dołoży tę odpowiedź do swojego „zbioru uczącego” jako nową informację. Natomiast roboty programistycznej w AI nie ma dużo. Są oczywiście inżynierowie, którzy piszą te sztuczne inteligencje, wielkie głowy tworzące bazowy mechanizm – „model mózgu sytemu”. A gdy on już powstanie, to sztuką jest nauczyć go tego, czego chcemy i to nauczyć dobrze, czyli podać dobre obrazy roślin, z dobrymi opisami, przypadkami szczególnymi etc. Kwiat może przecież wyglądać inaczej zależnie od pory dnia czy warunków robienia fotografii, która jest danymi wejściowymi dla aplikacji. Na tym się trzeba znać, dlatego przy tworzeniu baz pracują też specjaliści z danej dziedziny.

Kilka tygodni temu programista „superinteligentnego chat-bota LaMDA” z Google’a Blake Lemoine uznał, że tworzona przez niego AI „zyskała świadomość”. Na bok odłóżmy kwestię, co to jest świadomość, bo każda nauka ma tu własną definicję. Skupmy się na kwestiach technicznych: co pana zdaniem tam się stało?

Sztuczna inteligencja działa na trzech polach. Pierwsze, podstawowe i najstarsze, to tak zwana

business inteligence. Ma zastosowanie w dużych przedsiębiorstwach, które generują olbrzymie bazy danych, choćby księgowych, kadrowych, marketingowych, sprzedażowych etc. Menedżerowie oczekują, że po wrzuceniu tych baz do AI system zobaczy jakieś korelacje, które gołym okiem są nie do wykrycia. Input – wejście – to surowe dane, a output – wyjście – to też dane, tylko będące już efektem analizy. W

business intelligence najczęściej dokonują jej prostsze mechanizmy, zwane

machine learning, które analizują dane mechanicznie i raczej nie podchodzą do nich kreatywnie.

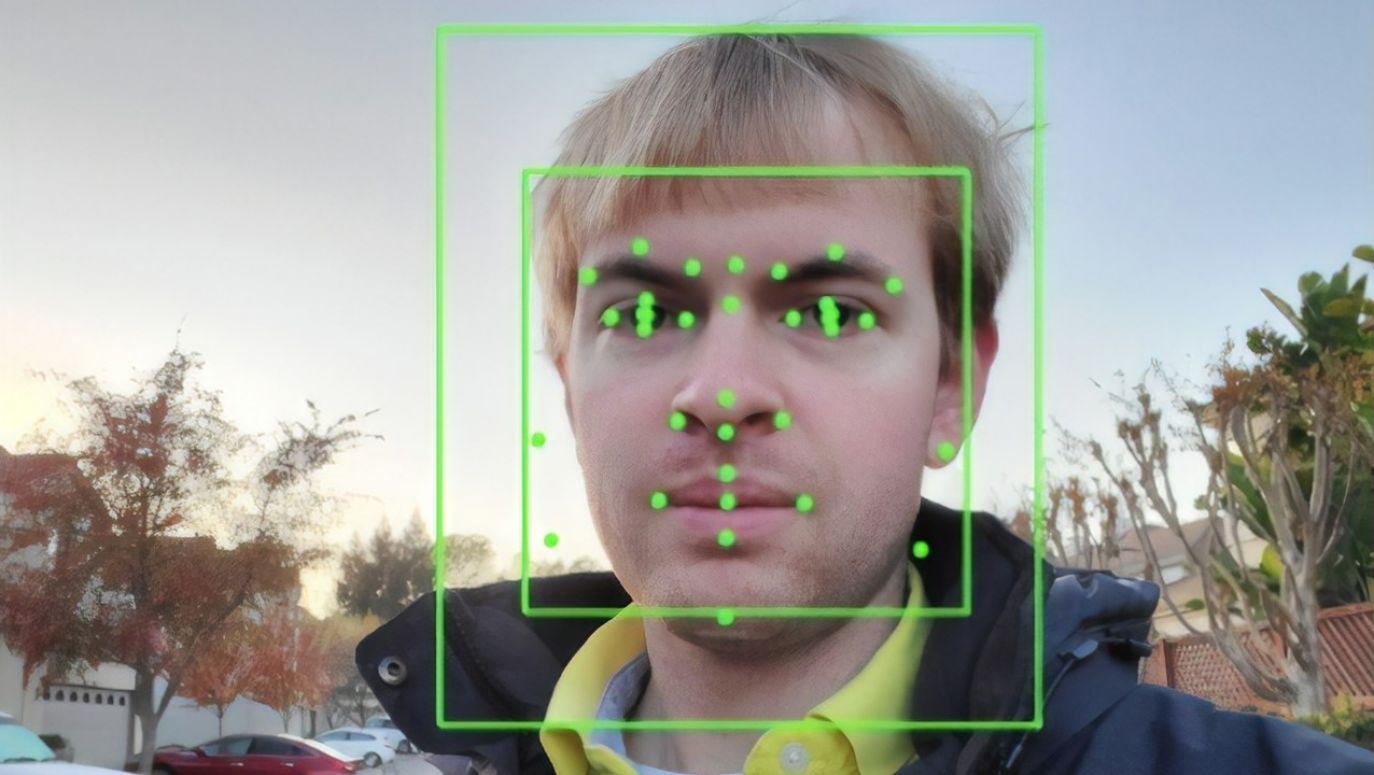

Drugie pole działania AI to wspomniane już rozpoznawanie rzeczy. W różnym zakresie: od gadżetów po poważne zastosowania cywilne (jak diagnostyka nowotworów na podstawie metod obrazowania, czy

identyfikacja osób po danych biometrycznych) i militarne (np. rozpoznawanie obiektów wojskowych na obrazach satelitarnych). W tej dziedzinie AI pomaga ludziom robić to, co sami potrafią, ale w przeciwieństwie do nich ona się nie męczy i zakładamy, że nie kieruje się uprzedzeniami.

ODWIEDŹ I POLUB NAS

ODWIEDŹ I POLUB NAS